«Негатыўны наступ» і смяротныя лабараторыі: як штучны інтэлект выкрывае расійскую прапаганду

Як штучны інтэлект дапамагае выкрываць феномен ХХІ стагоддзя — расійскую прапаганду? Платформы сацыяльных сетак у асноўным ствараюцца амерыканскімі кампаніямі... і потым выкарыстоўваюцца злачынцамі, найперш расіянамі для дэзінфармацыі.

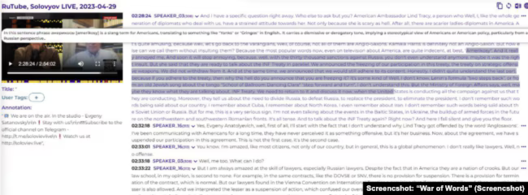

Старонка праекта «Вайна слоў», якая змяшчае больш за 100 000 гадзін рускага відэа з англійскай транскрыпцыяй.

Расія сама вельмі часта выкарыстоўвае штучны інтэлект для распаўсюджвання хлусні ў сацыяльных сетках, створаных амерыканскімі кампаніямі, і гэтыя навіны арыентаваныя на заходніх чытачоў, піша «Голас Амерыкі».

Даследчыкі дэзінфармацыі кажуць, што Расія з'яўляецца лідзіруючай краінай у распаўсюджванні фальшывых відэа і паведамленняў з выкарыстаннем штучнага інтэлекту (ШІ).

Нягледзячы на сваю недасканаласць, сістэмы штучнага інтэлекту дазваляюць прапагандысцкай машыне Крамля хутка і танна даносіць хлусню да вялікай колькасці гледачоў і чытачоў.

«Інфармацыйным аб'ектам» падобных расейскіх фэйкаў і ўкідаў даследчыкі называюць жыхароў ЗША, якія штодня сутыкаюцца з патокам фэйкавых навін, часта не падазраючы, што большая частка іх вырабляецца ў Расеі.

У той жа час амерыканскія і ўкраінскія спецыялісты паступова асвойваюць сістэмы штучнага інтэлекту, каб выкрываць расейскія фэйкі.

Глядзіце таксама

Як штучны інтэлект дапамагае чытаць рускае «новамоўе» па-англійску

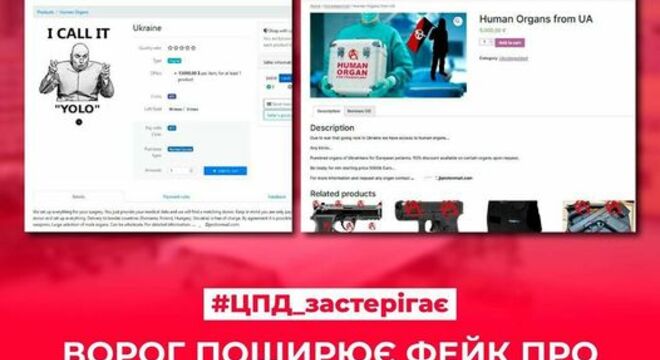

На дзяржаўным узроўні Украіна пакуль толькі вывучае магчымасці штучнага інтэлекту для барацьбы з расейскімі фэйкамі, паведамілі «Голасу Амерыкі» ва ўрадавым Цэнтры стратэгічных камунікацый і інфармацыйнай бяспекі.

У той жа час з'яўляюцца асобныя ініцыятывы. Так, у чэрвені ўкраінскія распрацоўшчыкі прэзентавалі інтэрнэт-сховішча прапаганды «Вайна слоў», у якім сабраны расейскія тэлепраграмы RuTube і часткова Telegram за апошнія 12 гадоў.

Інтэрнэт-карыстальнікі могуць знайсці ў адкрытым доступе больш за 100 тысяч гадзін прапагандысцкіх відэаролікаў з транскрыпцыяй на рускай і англійскай мовах. Такі архіў быў створаны з прыцягненнем штучнага інтэлекту.

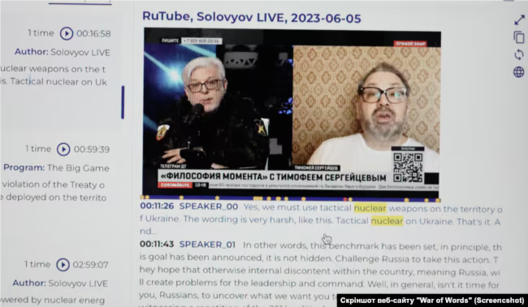

«Гэты інструмент дазваляе любому чалавеку на англійскай мове атрымаць доступ да інфармацыі пра тое, чым Расея пагражае ўсяму заходняму свету: усе гэтыя пагрозы падарваць ядзернай зброяй, знайсці месцы «прыняцця рашэнняў» і г. д.», — распавядае кіраўнік праекта, медыйнік, міністр культуры, моладзі і спорту Украіны ў 2019-2020 гадах Уладзімір Барадзянскі.

Скрыншот сайту «Вайна словаў», дзе тлумачыцца кантэкст, у якім расейцы ўжываюць слова «хахлы»: «для прыніжэння ўкраінскай нацыянальнай ідэнтычнасці».

Барадзянскі кажа, што яны спрабавалі адаптаваць пераклад такім чынам, каб англамоўныя гледачы зразумелі кантэкст і змаглі ўбачыць «рускае новамоўе, паводле якога мір — гэта вайна, не выбухі — а “хлапкі”, не адступленне — жэст добрай волі».

З дапамогай сістэмы пошуку можна знайсці ўсе праграмы па тэмах, напрыклад, ядзерная зброя. Ці ўсе перадачы, у якіх украінцаў называюць «хахламі».

Словы, якія цяжка зразумець людзям, што не валодаюць рускай мовай, у тым ліку абразы ў адрас амерыканцаў, штучны інтэлект дапамог перакласці з тлумачэннямі.

Глядзіце таксама

«Мы зрабілі гэта з дапамогай штучнага інтэлекту, не перакладаючы ўсё на фармальную мову, а выкарыстоўваючы выразы, якія падкрэсліваюць эмацыйны стан у расійскай тэлестудыі», — тлумачыць тэхнічны дырэктар праекта «Вайна слоў» Андрэй Арнацкі.

Напрыклад, словы, якія часта выкарыстоўваюцца расейцамі для звароту да амерыканцаў — такія як «піндос» або «амерыкос» — утрымліваюць у перакладзе на англійскую мову заўвагу з англійскай інтэрпрэтацыяй: «гэта слэнгавы тэрмін, якім называюць амерыканцаў, што перакладаецца як «янкі» або «грынга» і мае грэбліва-зняважлівы тон».

«Гэта дазваляе любому англамоўнаму зразумець, з якой пазіцыяй і з якой агрэсіяй пра гэта распавядаецца на расейскіх каналах», — растлумачыў Арнацкі.

Тлумачэнне слова «амерыканцы», якое выкарыстоўваецца на расійскім тэлебачанні: «слова кшталту «янкі» і «грынга», якое мае прыніжальна-зняважлівае адценне».

«Тут выкарыстоўваўся штучны інтэлект, каб максімальна наблізіць пераклад да першакрыніцы», — кажа Барадзянскі.

Сістэма таксама дазваляе даследаваць, наколькі актыўна і калі расейцы пачалі выкарыстоўваць пэўныя наратывы, што, маўляў, адбываецца па камандзе.

«Можна злавіць час, калі замест выбухаў пачалі ўжываць слова «хлапок» і рабіць «негатыўны наступ», ці, як яны кажуць, «жэст добрай волі». І гэта вельмі цікава — з якіх каналаў яны гэта кажуць... яны пачынаюць казаць аднолькавыя рэчы і заўсёды ў адзін і той жа час — гадзіна ў гадзіну», — сказаў Арнацкі.

Уладзімір Барадзянскі спадзяецца, што ўкраінскі інструмент дазволіць даследчыкам, асабліва заходнім, лепш вывучаць расейскую прапаганду, якую ён называе феноменам ХХІ стагоддзя:

«Калі частка сям'і тут (ва Украіне, — рэд.), а частка сваякоў у Расеі, і яны кажуць: «Не, не, вы не разумееце, усё добра, мы вас вызваляем», — у многіх здарылася прасвятленне. А як гэтая расійская прапаганда насамрэч працуе? Што такое можна было сказаць брату, сястры, маці, каб яны больш верылі расійскай прапагандзе, а не сваім сваякам ва Украіне?»

Скрыншот сайта «Вайна слоў», пошук тэзісаў пра ядзерныя пагрозы

Паводле Барадзянскага, асабліва важна, каб англамоўная аўдыторыя разам з тэкстам бачыла відэа з эмоцыямі расійскіх эфіраў, бо само відэа адыгрывае ключавую ролю ў прапагандзе:

«Мы ведаем, што сярод людзей, якія глядзяць тэлебачанне (расейскае. — рэд.), 80% падтрымліваюць вайну. Сярод людзей, якія не глядзяць тэлебачанне, 40% падтрымліваюць вайну. Гэта іх лічбы, з расійскага даследавання».

Дапамога штучнага інтэлекту ў выкрыцці хлусні аб «смяротных лабараторыях» Pfizer і замаху на Карлсана

Выкарыстанне штучнага інтэлекту для барацьбы з прапагандай знаходзіцца ў зачаткавым стане і ў ЗША, кажа Дарэн Лінвіл, аналітык па дэзінфармацыі ў сацыяльных сетках і дацэнт Даследчага ўніверсітэта Клемсана ў Паўднёвай Караліне.

Гэта парадокс, кажа ён, таму што Расея сама магутна выкарыстоўвае штучны інтэлект для распаўсюджвання хлусні ў сацыяльных сетках, створаных амерыканскімі кампаніямі:

«Самі сацыяльныя медыя-платформы ствараюцца на Захадзе, яны ствараюцца і кіруюцца ў асноўным амерыканскімі кампаніямі. А затым гэтыя тэхналогіі выкарыстоўваюцца злачынцамі, у асноўным расейцамі — са сваімі мэтамі і без асаблівага кантролю з боку кампаній, якія ўкараняюць гэтыя тэхналогіі», — кажа Лінвіл.

У цяперашні час група даследчыкаў з Універсітэта Клемсана асвойвае магчымасці выкарыстання штучнага інтэлекту для выяўлення фэйкаў і прапаганды, якія раней таксама ствараліся штучным інтэлектам:

«Штучны інтэлект — гэта інструмент, які можна выкарыстоўваць, каб паспрабаваць аддзяліць іголку ад стога сена, разбіць пэўныя рэчы на катэгорыі, якія потым можна паспрабаваць зразумець», — тлумачыць аналітык.

Глядзіце таксама

Такім чынам, магчымасці штучнага інтэлекту дапамаглі аналітыкам з Універсітэта Клемсана даследаваць расійскі след у шэрагу гісторый. У прыватнасці, пра «замах» на амерыканскага тэлевядоўцы Такера Карлсана.

«Некалькі месяцаў таму журналіст Такер Карлсан наведаў Маскву, узяў інтэрв'ю ў Пуціна і зайшоў у прадуктовую краму, нястомна распавядаючы пра тое, як там усё цудоўна. І адразу пасля гэтага з'явілася гісторыя, што Украіна спрабуе забіць Такера Карлсана. Гэтая гісторыя была цалкам сфабрыкаваная расейцамі», — кажа Лінвіл.

Ён тлумачыць, што пры дапамозе штучнага інтэлекту змог выявіць, што гэты фэйк першапачаткова з'явіўся на трох асобных сайтах, кожны з якіх звязаны з Расіяй і кожны створаны з дапамогай ШІ.

«Напрыклад, калі я хачу паглядзець на размовы пра замах на Такера Карлсана, якога насамрэч ніколі не было, штучны інтэлект можа дапамагчы мне зразумець: якім чынам людзі гавораць пра гэта, якія розныя словы выкарыстоўваюцца для апісання гэтага, якія выявы або відэа выкарыстоўваюцца для гэтых размоў», — растлумачыў даследчык.

З дапамогай штучнага інтэлекту амерыканскім даследчыкам удалося высветліць паходжанне фэйку пра амерыканскія лабараторыі ва Украіне і тое, што больш за 40 украінскіх дзяцей у Кіеве загінулі падчас выпрабаванняў новай вакцыны Pfizer.

«Гэтая гісторыя, вядома, цалкам сфабрыкаваная расейскімі хакерамі, якія выкарыстоўвалі гэтыя (створаныя ШІ і звязаныя з Расіяй) вэб-сайты для далейшага распаўсюджвання ў сацыяльных сетках. Першапачаткова яна была апублікаваная на вэб-сайце пад назвай The Chicago Chronicle, які пасля быў зачынены», — тлумачыць Лінвіл.

Скрыншот сайта The Chicago Chronicle з артыкулам пра гібель украінскіх дзяцей падчас выпрабаванняў новай вакцыны Pfizer

Па словах даследчыка, штучны інтэлект дапамагае расійскім прапагандыстам падтрымліваць і напаўняць інфармацыяй шэраг інтэрнэт-рэсурсаў, замаскіраваных пад амерыканскія сайты.

«Яны ствараюць сайты накшталт DC weekly.com або з назвамі іншых амерыканскіх гарадоў і выкарыстоўваюць штучны інтэлект для крадзяжу гісторый з іншых сайтаў, рэгулярна абнаўляюць кантэнт і робяць гэтыя вэб-сайты падобнымі на сапраўдныя старонкі навін», — тлумачыць Лінвіл.

Глядзіце таксама

«Калі змантаваць маніпулятыўна, вы можаце зрабіць Байдэна падобным да старога, які хістаецца»

Паколькі пагроза дэзінфармацыі ўзрасла да велізарных памераў, у ЗША з'явіліся прыватныя кампаніі, якія ствараюць праграмы на аснове штучнага інтэлекту, што дапамагаюць выяўляць фальшывыя навіны.

«З дапамогай нашага інструмента вы можаце ўзяць частку змесціва, або, скажам, 10 000 частак змесціва, прапусціць яго праз сістэму, і гэта дасць вам ацэнку ўпэўненасці адносна таго, ці з'яўляецца гэта глыбокай падробкай або дэзінфармацыяй. Звычайна ўсё, што дае сістэма, больш чым на 50%, гэта сапраўды паказвае прыкметы маніпуляцыі», — кажа Эма Браўн, сузаснавальніца Deep Media АІ.

Паводле яе слоў, такія інструменты на аснове штучнага інтэлекту выкарыстоўваюцца як уладамі, так і кампаніямі, якія валодаюць сацыяльнымі сеткамі.

«Нашы інструменты дазваляюць, напрыклад, кампаніям сацыяльных сетак не толькі вызначаць, што праўда, а што падробка, але таксама ведаць, што можа быць шкоднаснай інфармацыяй, і дапамагаць выяўляць яе на ранняй стадыі, каб карыстальнікі заставаліся ў бяспецы», — кажа Браўн.

Глядзіце таксама

Пры гэтым яна прызнае, што рэгуляванне непраўдзівай інфармацыі, асабліва ў сацыяльных сетках, знаходзіцца на недастатковым узроўні:

«Мы ўсё яшчэ знаходзімся на ранняй стадыі рэгулявання фальшывага кантэнту. Гэта адна з найважнейшых праблем нашага часу. Але мы бачым вялікую цікавасць да гэтай праблемы з боку людзей, з якімі мы размаўляем... Я вельмі рады бачыць людзей, якія прымаюць гэты выклік».

Галоўнай праблемай Браўн называе фальшывыя відэа, створаныя з дапамогай штучнага інтэлекту:

«У 2020 годзе гэта было не тое, што мог стварыць звычайны чалавек. Толькі нешматлікія людзі ведалі, як ствараць дыпфейкі. А цяпер людзі могуць ствараць іх на сваіх тэлефонах, і гэта складаная задача і вялікі фактар рызыкі», — кажа яна.

Па словах Лінвіла, танныя падробленыя відэа могуць быць такімі ж эфектыўнымі, як і больш складаныя дыпфейкі, якія цяжка ідэнтыфікаваць:

«Мы бачым гэта зараз у амерыканскай палітыцы. Напрыклад, яны могуць зрабіць відэа прэзідэнта Байдэна, дзе ён, магчыма, крыху блукае. Але калі вы адрэдагуеце яго маніпулятыўна, вы можаце зрабіць яго падобным на старога, які хістаецца...»

Глядзіце таксама

Фальшыўка, якую «выдалі» гальштукі

Нягледзячы на намаганні даследчыкаў больш эфектыўна выкарыстоўваць штучны інтэлект для барацьбы з расійскай прапагандай, яны кажуць, што звычайныя спажыўцы інфармацыі могуць самі распазнаць шмат фэйкаў.

Спецыялісты ў галіне дэзінфармацыйных даследаванняў падкрэсліваюць, што штучны інтэлект недасканалы, і раяць звяртаць увагу на дэталі: на фальшывых фота і відэа часта відаць недарэчныя рукі, адзенне, упрыгожванні або выраз твару.

Так адбылося ў выпадку з фальшывым відэа з заявай прэс-сакратара Дзярждэпартамента ЗША Мэцью Мілера.

У пачатку чэрвеня расійскія Telegram-каналы распаўсюдзілі відэа з ягонымі нібыта словамі пра тое, што ў Белгарадзе няма мірных жыхароў, і таму ЗША лічаць горад законнай мішэнню для ўкраінскіх удараў.

Пры гэтым у пачатку відэа ў прэс-сакратара сіні гальштук, а пасля пытання журналіста ён змяняецца на ружова-чырвоны.

Як адзначае The New York Times, фэйк з'явіўся праз дзень пасля таго, як прадстаўнікі ЗША заявілі, што Украіна можа выкарыстоўваць амерыканскую зброю для абмежаваных удараў па Расеі.

«Ці гэта былі змантаваныя кліпы з маіх слоў, дзе я кажу адно слова, а іх мантуюць па-рознаму, ці гэта версія штучнага інтэлекту — мы пакуль не ведаем. Мы яе вывучаем», — так Мэцью Мілер асабіста пракаментаваў гэты відэафэйк на брыфінгу 5 чэрвеня.

Пры гэтым ён жартаўліва папярэдзіў гледачоў і журналістаў быць пільнымі на відэа, на якіх ён фігуруе:

«Калі вы бачыце відэа са мной і колер майго гальштука і кашулі, які мяняецца з моманту, калі мне задаюць пытанне, да моманту, калі я адказваю, гэта відавочны паказчык таго, што відэа фальшывае».

Тым часам журналісты The New York Times адзначылі, што, нягледзячы на бачныя прыкметы маніпуляцыі, 49-секундны відэаролік з Мілерам ілюструе «ўзрастаючую пагрозу дэзінфармацыі і асабліва відэаролікаў deepfake, створаных з дапамогай штучнага інтэлекту».